Progresos del pensamiento científico

El acontecimiento cultural más creativo del siglo xx fue la aparición de una nueva perspectiva científica y sus efectos en el pensamiento y la vida de la humanidad.

Con un comienzo que coincidió con el del siglo, los científicos concibieron una nueva visión de la naturaleza y sus leyes que supuso un rompimiento tan brusco con el pensamiento que la precedió como el de las indagaciones científicas de los siglos xvi y xvii con el pensamiento del Medioevo.

El nuevo pensamiento científico podría muy bien ser calificado de segunda revolución en la ciencia. La primera gran revolución científica había creado el método científico de indagación. Contemplado desde la perspectiva del siglo XX, el despliegue del pensamiento científico entre 1500 y 1700 se manifiesta decisivo en la creación de la civilización moderna. Según un historiador contemporáneo, el profesor Herbert Butterfield, «supera a cuanto ha ocurrido desde la aparición del cristianismo y reduce el Renacimiento y la Reforma al rango de meros episodios».

La primera revolución científica fue una revolución intelectual; enseñó a los hombres a pensar de modo diferente. Sólo más adelante fue aplicado este pensamiento a una nueva especie de uso práctico, en los progresos industriales que dieron a la civilización moderna su carácter exterior. Al término del siglo xix, el método científico no se había limitado a provocar cambios profundos en la visión de las cosas; la ciencia estaba rehaciendo al mundo, de arriba abajo.

También la segunda revolución científica comenzó como una revolución intelectual. Hacia el año 1900, la visión de la naturaleza que estableció la primera revolución científica comenzó a disminuir su éxito y a tropezar con los primeros fracasos. Se advirtieron aquí y allí delicados fenómenos nuevos que no podía descifrar la visión de la naturaleza y sus leyes establecida anteriormente. Como consecuencia, los hombres de ciencia, lentamente y con vacilaciones, comenzaron a formar una nueva concepción de los procesos de la naturaleza y un nuevo planteamiento de la misma actividad científica. El desplazamiento en la teoría establecida fue sutil, pero caló muy hondo.

Como su predecesora, la segunda revolución científica se extendió lentamente desde las mentes de los especialistas que la concibieron. En el curso de cincuenta años, sus consecuencias prácticas tuvieron muy largo alcance; muchas de las espectaculares aplicaciones de la ciencia en los años que siguieron a la segunda guerra mundial surgieron de los nuevos conceptos y del nuevo planteamiento. Con el tiempo, esta revolución comenzó a transformar el punto de vista del lego del mismo modo que el del científico y a entrar en las mentes y afectar las vidas de la gente en el mundo entero.

La física, las matemáticas, la biología hacia 1890

El carácter de la revolución en el pensamiento científico sólo puede ser comprendido teniendo presente, en segundo término, lo que se sabía y se pensaba al término del siglo xix.

En la mayoría de los aspectos, las ciencias físicas parecían haber llegado en la década de 1890 casi a las fronteras del conocimiento. Existía una coherente leona de la estructura de la materia que explicaba los fenómenos conocidos. Según esta teoría, toda la materia consiste en átomos, que forman una ordenación regular cuando la materia se halla en estado sólido, pero que se mantienen juntos de modo progresivamente más inestable cuando la materia pasa al estado líquido y luego al gaseoso. Eran ya conocidas unas ochenta clases de átomos esencialmente diferentes. Se sabía que correspondían químicamente a grupos cíclicos, con notables similitudes de actividad física y química dentro de cada grupo. Pero nada se sabía o conjeturaba como explicación de las diferencias entre los átomos de una clase y los de otra o de las similitudes entre las distintas clases de átomos pertenecientes a un mismo grupo cíclico.

Como se imaginaba a los átomos, conforme al nombre que les dieron los griegos, indivisibles, no había realmente un sentido en el que sus diferencias o sus semejanzas pudieran ser estudiadas. Porque para explicar una diferencia material hay que señalar, según es de presumir, alguna diferencia básica en la constitución o la ordenación. No cabía suponer constitución u ordenación en un átomo indivisible. Conforme a esta opinión, cada átomo es un ente fundamental, completo y encerrado en sí mismo; sus propiedades podían ser descritas, pero no referidas a cualesquiera principios básicos más profundos.1

Se sabía que las diferentes clases de átomos se combinaban en muchas estructuras químicas diferentes. Se habían encontrado leyes descriptivas que mostraban cómo los átomos se mantenían juntos en esas estructuras. Se suponía que los átomos de sodio y cloro, cuando se combinan químicamente para constituir la sal de mesa, se mantenían mutuamente en sus puestos ocupando los ángulos de un enrejado cúbico. Se había deducido que, en algunos hidrocarburos, los átomos de carbono forman largas cadenas abiertas y, en otros, están enlazados, seis a la vez, en anillos cerrados.

Estas imágenes de estructuras químicas se habían revelado como poderosas guías para el descubrimiento, especialmente en el estudio de las sustancias con componente de carbono que intervienen en todos los procesos de la vida. Habían permitido ya sintetizar muchas nuevas sustancias. Nada se sabía, sin embargo, de las fuerzas que presumiblemente actúan cuando los átomos son mantenidos juntos en tales estructuras estables.

Los científicos reconocían, desde luego, que el mundo físico no consiste simplemente en materia, sino también en fuerzas entre los trozos de materia y en radiaciones que pasan de un trozo de materia a otro. De las fuerzas conocidas, la más importante históricamente seguía siendo la fuerza de gravitación, que Isaac Newton (1642-1727) había concebido en primer lugar como extendiéndose desde cualquier trozo de materia a través del espacio. Newton había aportado así, de un solo golpe, orden y comprensión en los movimientos de todos los cuerpos celestes y su proeza parecía en 1890 tan sobresaliente como en el día en que los Principia habían sido publicados, en 1687. En fecha anterior del siglo XIX cuando el distante planeta Urano pareció poco puntual, los astrónomos John Couch Adams (1819-1892), en Gran Bretaña, y Urbain Jean Joseph Leverrier (1811-1877), en Francia, habían calculado que un planeta menor debía estar perturbándolo. Entregado cada cual a su tarea sin conocimiento del otro y sin nada más que lápiz, papel y las leyes de Newton, los dos calcularon dónde tenía que estar aquel planeta. Y, desde luego, cuando el gran telescopio de Berlín fue orientado hacia el lugar determinado por Leverrier, allí se había manifestado Neptuno, claro a la vista y espectacular en su vindicación de las leyes newtonianas.

También se conocían las fuerzas de la electricidad y el magnetismo y se estableció entonces que cada una de ellas podía inducir a la otra. Además, James Clerk Maxwell (1831-1879) había ofrecido en la década de 1860 las razones teóricas para creer que una radiación como la luz podía ser una perturbación electromagnética propagada a través del espacio. Si esto era así, las perturbaciones electromagnéticas podían muy bien crear otras formas de radiación no descubiertas hasta entonces y el joven Heinrich Rudolf Hertz (1857-1894) acababa de producir nuevas radiaciones de esta clase; resultó más adelante que eran las ondas de radio. También fueron descubiertas en 1895 por Wilhelm Konrad von Rontgen (1845-1923) nuevas radiaciones a las que se llamó rayos X. Se estaba haciendo manifiesto que la luz visible no constituía más que una fracción de las radiaciones electromagnéticas en las que las longitudes de ondas iban desde el ultravioleta hasta los rayos X y del infrarrojo a largas ondas radiofónicas.

Subsistía la cuestión de qué era lo que llevaba a estas radiaciones electromagnéticas de un punto a otro. Se sabía que el sonido era una perturbación física del aire; se propaga en el aire y es el aire lo que lleva sus ondas de un punto a otro y de hecho las forma. Si se extrae el aire de un globo hueco de vidrio, ningún sonido puede cruzarlo. Sin embargo, la luz lo cruza. ¿Qué es lo que conduce las ondas luminosas? Y ¿qué es lo que conduce las otras radiaciones electromagnéticas, de las que la luz es únicamente una banda sensible para el ojo humano?

Heinrich Rudolf Hertz: Foto Agencia AGE.

Wilhelm Konrad von Rontgen. Foto Agencia AGE

Fotografía de un esqueleto humano visto por medio de los rayos X (1896). Foto Agencia AGE. Las PERTURBACIONES electromagnéticas podían muy bien crear otras formas de radiación no descubiertas hasta entonces y Heinrich Rudolf Hetz: acababa de producir nuevas radiaciones de esta clase; resultó más adelante que eran las ondas de radio. También fueron descubiertas más adelante (1895) por Wilhelm Konrad von Rontgen nueva radiaciones a las que llamó rayos X.

A esta pregunta el siglo xix contestó: el éter. Tal era el medio universal que los científicos sostuvieron que conducía las diferentes radiaciones a través del espacio. Se suponía así que el éter traía la luz de las estrellas hasta nosotros, del mismo modo que el calor del sol del que nuestras vidas dependen. Tenía de hecho que llevar de lugar a lugar toda esa energía que no es directamente transmitida por el movimiento de la materia. Para hacer esto, sin embargo, resultaba que el éter como transmisor de energía debía tener propiedades extraordinarias y en muchos aspectos contradictorias, completamente distintas de las de cualquier material conocido. Por esta razón, el éter era el principal enigma para los científicos al término del siglo XIX.2

Había habido notables ampliaciones en el campo de la matemática, disciplina en la que siempre se apoyaron fuertemente las ciencias físicas y a la que debían buena parte de sus éxitos. Aunque en Gran Bretaña los matemáticos se habían interesado especialmente en problemas relacionados con la mecánica y la física, en el continente de Europa la matemática pura había alcanzado mayores niveles. Habían sido descubiertas las geometrías no euclidianas. Se habían encontrado rigurosos métodos para el estudio de cantidades infinitesimales e infinitas. Se había demostrado que la distinción que los griegos habían conocido, entre números que pueden ser escritos como fracciones y los que no pueden serlo, podía ser afinada más; es posible dar definiciones precisas de números, por ejemplo, de la razón de la circunferencia de un círculo a su diámetro, que no pueden ser expresados por ninguna ecuación algebraica. Quedó abierto todo un campo de trabajo en el estudio de nuevas funciones y en la aplicación a ellas de procesos matemáticos que hasta entonces habían estado limitados a los espacios lineales. Se habían hallado nuevos métodos para abordar algunos de los atractivos problemas de la teoría de los números.

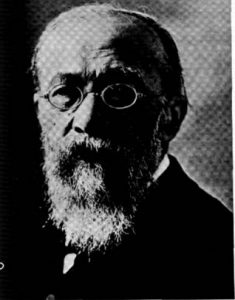

Leopold Kronecker. Fotografía de 1870. Tanto para el matemático puno como para el aplicado, la matemática, en la segunda mitad del siglo XIX. Continuó siendo en el fondo un asunto de mediciones y. por consiguiente, de números. La formación mental de estos científicos podía ser resumida por una observación atribuida al matemático alemán L. Kronecker: «Dios hizo los números enteros: todo lo demás es obra del hombre.» Foto Agencia AGE.

Sin embargo, tanto para el matemático puro como para el aplicado, la matemática en la segunda mitad del siglo xix continuó siendo en el fondo un asunto de mediciones y. por consiguiente, de números. La formación mental de estos científicos podía ser resumida por una observación atribuida al matemático alemán L. Kronecker (1823-1891): «Dios hizo los números enteros; todo lo demás es obra del hombre.» Los números básicos, los números enteros, eran algo que debía darse por supuesto; estaban, en un sentido, dados por Dios.3

El desarrollo más espectacular del siglo XIX se había producido en biología, como resultado de la publicación en 1859 de El origen de las especies por Charles Darwin (1809-1882). La proeza de Darwin fue doble, Reunió un vasto conjunto de pruebas en apoyo de la teoría de que la evolución se había producido y descubrió un mecanismo científicamente aceptable para su explicación.

El argumento en favor de la evolución fue reforzado por el descubrimiento, hacia la misma época, de la unidad común a todas las formas vivas, la célula. Un ser vivo difiere de otro en el número de células que se asignan a diferentes usos y en la complejidad de la organización que se les da. Pero, como Theodor Sehwann (1810-1882) estableció en 1839, todos están formados por células y, básicamente por tanto, todos pueden ser descritos como diferentes reuniones de las mismas unidades.

La exposición por Darwin del principio de la selección natural fue tan importante para la biología como los Principia de Newton para la mecánica y la astronomía, aunque de un modo distinto. Hizo científicamente comprensibles la variedad y el desarrollo de la vida. Todos los organismos son variables y algo de la variación es transmisible por herencia. La selección artificial practicada por el hombre puede acumular variaciones hereditarias deseables para producir nuevas razas. En la naturaleza, hay una superproducción de progenie y, por consiguiente, una lucha por la existencia (véase la nota adicional 1 de final de capítulo). Los individuos con variaciones hereditarias favorables tenderán a sobrevivir en mayor número. Una especie puede, en consecuencia, cambiar gradualmente en el curso de generaciones. Darwin llamó selección natural a este principio de la supervivencia diferencial y de la reproducción de variaciones hereditarias favorables.

La debilidad de la teoría de la evolución de Darwin estribaba en la ausencia de una ciencia de la genética: el mecanismo mediante el cual surgen variaciones y se transmiten características hereditarias, incluidas variaciones nuevas.4

El siglo xix había descubierto que toda la vida existente surge de vida preexistente, o sea, que la vida es materia que se reproduce a si misma; que la mayoría de las formas conocidas de vida consisten en células que contienen un núcleo organizado; que la mayor parte del crecimiento entraña la división de células, incluida la división exacta del sistema nuclear; que la reproducción en organismos unicelulares es por división de células y en organismos multicelulares por células únicas o grupos de células que se desprenden.

En la reproducción sexual se unen los núcleos de dos células únicas desprendidas. Pero todavía estaba muy difundida la creencia de que esto suponía alguna mezcla o fusión de cualquier cosa que se transmitiera.

Si esto fuera así, la progenie de un cruzamiento se haría progresivamente menos diferenciada y las variaciones hereditarias tenderían a desaparecer. Este dilema no fue admitido como resuello hasta después de 1900. Entretanto, sin embargo, aceptado el hecho indudable de que se producen variaciones y de que algunas de ellas son hereditarias, la selección natural seguía siendo un principio válido. Buena parte de la biología de los últimos tiempos del siglo XIX estuvo dedicada a una nueva interpretación de los hechos biológicos a la luz de este principio. La clasificación, la anatomía comparada, la embriología y otras antiguas divisiones de la biología quedaron transformadas por la hipótesis de la evolución. Pero la repercusión de la obra de Darwin se extendió más allá de los límites de la misma biología antigua. Tal ve/ ningún descubrimiento desde Copérnico repercutió con tanta fuerza como el de Darwin en todos esos campos de la ciencia y la filosofía que se referían a la posición del hombre en el universo. El reconocimiento del hecho de que el hombre está sometido a las mismas leyes biológicas de otros organismos y que ya no puede considerarse biológicamente aparte de ellos llevó no solamente al derrumbamiento de viejas creencias religiosas, sino también al desarrollo de nuevas doctrinas filosóficas y a muchas nuevas percepciones psicológicas.

Las ciencias sociales: Marx, Durkheim

Las ciencias sociales en su forma empírica apenas habían nacido en la década de 1890. El filósofo francés Auguste Comte (1798-1857) había insistido en que el método positivo de pensar que caracterizaba a las ciencias naturales era la más alta fase de la razón humana y debía ser aplicado al comportamiento humano mediante el estudio científico de la sociología. Pero aunque sus principios positivistas conquistaron mucho favor, produjeron escasos intentos de determinar el funcionamiento de la sociedad mediante el examen de los datos sociales que comenzaban a ser acumulados. La cuidadosa reunión y el objetivo escrutinio de pruebas en el campo social habían sido especialmente practicados por la escuela de historiadores científicos desarrollada en las Universidades alemanas y se había extendido desde ellas por Europa y Estados Unidos. Los antropólogos sólo habían comenzado a analizar sistemáticamente las observaciones de las costumbres de pueblos primitivos anotadas por viajeros, misioneros y administradores coloniales y no habían creado sus propias técnicas para observar estas formas sociales que desaparecían rápidamente.’ El primer intento de estudiar la vida social en una ciudad moderna, Life and labour in London (La vida y el trabajo en Londres), de Charles Booth, fue emprendido en 1890.5

Se había formulado, sin embargo, un considerable conjunto de teoría social en el esfuerzo por describir y predecir los fenómenos sociales. Se había elaborado durante el siglo xix una teoría económica con el propósito de explicar el comportamiento económico en las condiciones del capitalismo competidor, sobre los cimientos establecidos por La riqueza de las naciones (1776), de Adam Smith, y la presunción de que la motivación humana es racional. Economistas del continente europeo y de Estados Unidos ofrecieron el cuadro del funcionamiento de una economía gobernada por la ley de la oferta y la demanda, donde la esencia de las relaciones económicas es un cambio en el que cada cual busca su máxima ventaja y su mínimo costo y en el que la oferta y la demanda son igualadas por un precio flexible; desarrollaron un sistema de ecuaciones matemáticas con el que se pudiera expresar la totalidad de estas relaciones económicas. En esta visión de la sociedad, que proporcionó la base racional para una política del laissez-faire por parte del gobierno, la busca del propio interés por cada individuo suministraría el poder motivador para la economía, traería un continuo progreso económico y convertiría la ventaja de cada cual en el bien de todos.

Una teoría alternativa, desarrollada por Karl Marx (1818-1883), llegó a una apreciación diferente de los resultados de la busca del propio interés en una economía capitalista. Centrada su atención en el proceso de la producción y en la relación entre el empleador y el empleado en el sistema fabril, Marx vio al capitalismo llevando no a un continuo progreso económico, sino a una progresiva disparidad entre el explotador capitalista y el trabajador proletario y a sucesivas graves crisis económicas. Siguiendo, por un lado, al filósofo alemán Cicorg Wilhelm Friedrich Hegel (1770-1831), quien veía el desarrollo histórico como un proceso dialéctico de lucha de los contrarios por el que el espíritu universal se revela a si mismo, y adoptando, por otro, la tesis de que son los factores materiales, no los espirituales, los dominantes en la motivación humana, Marx formuló el materialismo dialéctico como un concepto de desarrollo histórico y predijo que la lucha de clases llevará a la revolución final y a la creación última de una sociedad sin clases (véase la nota adicional 2 de final de capítulo).

Otros teóricos sociales aplicaron la teoría de la evolución al análisis de la sociedad. En las manos de Herbert Spencer (1820-1903), el concepto de la supervivencia del más apto reforzó las conclusiones de los economistas del taisse-faire y justificó la posición de los individuos y pueblos que se elevan a la riqueza y el poder en la lucha competidora. Los antropólogos presumieron que las sociedades habían pasado por fases de evolución de estados inferiores a otros superiores y que las sociedades primitivas eran supervivencias de estados por los que sociedades más avanzadas habían ya pasado.

Las formulaciones alternativas de la naturaleza de la sociedad tenían en común una presunción de progreso, ya fuera por el proceso de la competencia, el del materialismo dialéctico o el de la evolución de fases inferiores de civilización a otras superiores.

Respecto a la psicología y el comportamiento de los individuos, buena parte de las pruebas en que las teorías se basaban se había tomado de la introspección de los filósofos. El concepto del organismo humano como mecanismo que respondía a estímulos, tomado de las nociones mecanicistas de las ciencias físicas, llevó a Wilhelm Wundt 11832-1920) en Leipzig y a sus discípulos en Europa y Estados Unidos a emprender estudios psicológicos de estímulos y reacciones en un planteamiento experimental para la comprensión de la conducta humana. Basados en la presunción de que las diferencias físicas estaban asociadas a cualidades de carácter, inteligencia y superior o inferior desarrollo, algunos sociólogos trataron de establecer la existencia de tipos criminales y los antropólogos físicos buscaron pruebas de características raciales. El sociólogo francés Émile Durkhcim (1858-1917) inició en la década de 1890 pasos hacia el estudio de la psicología de grupo al examinar el proceso mediante el que la acción recíproca de conciencias individuales produce síntesis en forma de creencias religiosas o juicios de valor que tienen autoridad a causa de su carácter colectivo.

Los fundamentos del pensamiento científico antes de 1900

En la base del conocimiento y del pensamiento científico en todas las zonas había varias fuertes presunciones comunes. Casi todas las ideas se ajustaban a cuatro preconceptos básicos o modos no expresados de contemplar la naturaleza que, a un mismo tiempo, reflejaban y dirigían el pensamiento de la época.

En primer lugar estaba el principio de que la naturaleza procede por una estricta cadena de sucesos de causa a efecto, con la configuración de causas en cualquier instante dado que determinan plenamente los sucesos del instante siguiente, y así por siempre jamás.

Se presumía que la incertidumbre aparente era el reflejo de la ignorancia; si el conocimiento fuera completo, sería siempre posible predecir el futuro con precisión. Esto había sido dicho explícitamente por el matemático francés Fierre Simón Laplace (1749-1827) en un pasaje famoso. Si nos dieran, dijo Laplace, los paraderos y las velocidades en este instante de cada átomo en el universo, quedaríamos en condiciones de predecir sus paraderos y velocidades en todos los instantes posteriores. Podríamos, pues, predecir sin la menor incertidumbre el destino de todo el universo, de sus moléculas y sus hombres, de sus nebulosas y sus naciones, desde ahora hasta la eternidad. En realidad, podríamos hacer más que esto, porque podríamos, del mismo modo que avanzar por el tiempo, remontarnos por él y reconstruir así hasta la eternidad el pasado.

Wilhelm Wundt. Fotografía de 1900. El concepto del organismo humano como mecanismo que respondía a estímulo llevó a Wilhelm Wundt a emprender estudios psicológicos de estímulos y reacciones en un planteamiento experimcnlal para la comprensión de la conducta humana. Foto Agencia AGE.

Retrato de John Rayleigh. Al principio del deierminisrno se unía un segundo principio que expresaba el estricto espíritu de la ciencia: el principio cuantitativo. Lord Rayleigh lo expresó en otro famoso pasaje, al decir que nuestras ideas se hacen claras únicamente cuando se hacen cuantitativas. Foto agencia AGE.

Escena de tráfico urbano en un puente sobre el Támesis, grabado del siglo XIX. El sociólogo francés Emile Durkheim inició en la década de 1890 pasos hacia el estudio de la psicología de grupo al examinar el proceso mediante el que la acción recíproca de conciencias individuales produce síntesis.

Al principio del determinismo se unía un segundo principio que expresaba el estricto espíritu de la ciencia: el principio cuantitativo. Según este principio, la ciencia consiste en medir cosas y establecer relaciones precisas entre las mediciones. Lord Rayleigh (1842-1919) lo expresó en otro famoso pasaje, al decir que nuestras ideas se hacen claras únicamente cuando se hacen cuantitativas, de modo que sólo lo que es mensurable es susceptible de estudio científico y realmente exacto y puede ser descrito como conocimiento con verdad. De acuerdo con esta opinión, la naturaleza debe ser descrita finalmente por números: coordenadas en el espacio, tiempos de sucesos y coeficientes descriptivos de propiedades físicas; y el conocimiento de la naturaleza progresa estableciendo las relaciones entre estos números. 8

El tercer principio básico, referente a las transiciones de la naturaleza de un estado a otro, era el principio de continuidad. Expresaba la idea, muy arraigada en la perspectiva de la época, de que los movimientos de la naturaleza son graduales. Pueden parecer repentinos y sorprendentes: un rayo, una explosión, la erupción de un volcán. Pero la brusquedad, decía el pensamiento científico de la época, es sólo aparente.

Para la mentalidad del siglo xix. los procesos de la naturaleza se mueven imperceptiblemente de instante a instante. Entre dos instantes cualesquiera hay otro instante más breve; entre dos posiciones cualesquiera hay una posición intermedia. Y la división podría continuar eternamente; los procesos de la naturaleza son infinitamente tenues y continuos.9

Con estos principios, el siglo XIX se imaginó que había en la naturaleza y en la ciencia un cuarto principio: el de la impersonalidad. El científico se consideraba a sí mismo no una persona, sino un instrumento: desapasionado, carente de prejuicios y en cierto modo más que humano. La naturaleza se mostraba como una gran máquina impersonal que seguía imperturbablemente su camino, que el observador humano sólo podía atisbar.

El hombre de ciencia no inventaba: veía. No utilizaba su imaginación, sino su observación. No creaba el orden entre los fenómenos naturales: humildemente lo encontraba. Inclusive considerándose un instrumento, no reconocía ninguna acción recíproca entre ese instrumento particular y los fenómenos bajo observación. 10

De este modo, el científico del siglo xix se excluyó a sí mismo de las artes imaginativas y creadoras. El determinismo, la medición, la continuidad y la impersonalidad eran partes de una visión: la visión de la ciencia como extraña a las incertidumbres y tensiones de la vida cotidiana.

Con el paso de un siglo al otro los hechos del descubrimiento científico obligaron a los investigadores a abandonar esta visión de la ciencia y la perspectiva de la naturaleza que entrañaba. Se hicieron una serie de descubrimientos y se confirmaron diversas irregularidades que ya no se ajustaban a los principios en que se basaban las teorías científicas aceptadas. Al verse ante las implicaciones de los nuevos descubrimientos, los científicos desarrollaron una visión fundamentalmente nueva de la naturaleza y de la actividad científica.

El descubrimiento del átomo y el de la relatividad

En las ciencias físicas, que habían parecido tan próximas a su culminación, surgieron serie tras serie nuevos hechos y conceptos más allá de lo que había parecido sería su límite de ulterior progreso. La visión de la naturaleza que los físicos revelaron a partir

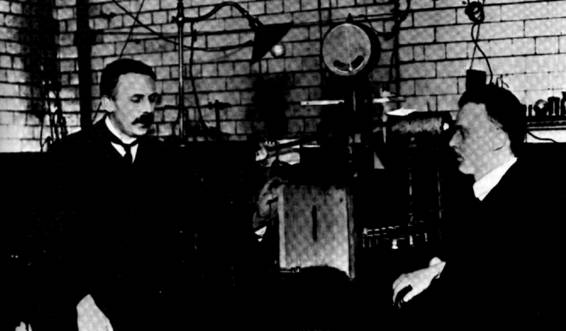

Ernest Rutherford en su laboratorio de Manchetier con Johann Gieiger. Fotografía de 1907. Foto Agencia AGE.

de 1900 era más rica y amplia que la soñada por el siglo xix c hizo más que las especulaciones de los filósofos para cambiar la perspectiva del siglo. Se descubrió que la unidad fundamental de la materia, el supuestamente indivisible átomo, tiene estructura y partes.

El descubrimiento procedió de la experimentación del paso de la corriente eléctrica por gases a baja presión, paso que da origen, en términos generales, al fenómeno que se aprecia en la iluminación de neón. En este fenómeno, la electricidad discurre, partiendodel cátodo, a lo largo del tubo.

Otto Hahn en el Deutsches Museum, de Munich repitiendo la experiencia con la que en 1938 logró la descomposición del átomo de uranio. Foto Agencia AGE.

El problema no resuelto en aquel tiempo consistía en saber si los rayos de electricidad que discurren por el tubo son meras ondas eléctricas o son partículas. En 1897, Joseph John Thomson (1856-1940) probó de modo concluyeme lo que otros habían ya casi probado: que los rayos catódicos son partículas, y mostró que tenían que ser mil veces más ligeras que el más leve de los átomos. Mostró además que su comportamiento era el mismo fueran cuales fuesen el gas que hubiera en el tubo y el metal que se utilizara como cátodo.

Thomson había descubierto el electrón dentro del supuestamente indivisible átomo. Más adelante, los discípulos de Thomson, encabezados por Ernest Rutherford (1871-1937), hallaron la relación estructural de las partes entre sí. Probaron que los electrones giran en una nube de órbitas alrededor del pesado interior o núcleo del átomo. En especial, Niels Bohr (1885-1962) mostró que el salto del electrón de una órbita a otra libera siempre la misma cantidad de energía y, de este modo, introdujo la nueva física del cuanto en la comprensión de la estructura atómica.

El núcleo seguía pareciendo indivisible, pero Henri Becquerel (1852-1908) había mostrado ya en 1896 que algunos átomos podían cambiar su naturaleza química espontáneamente y sin causa conocida. Becquerel y otros después de él, incluida madame Marie Curie (1867-1934), descubrieron la radiactividad, esencialmente la desintegración de un núcleo.

Físicos posteriores, que concentraron su atención en el núcleo, establecieron finalmente la posibilidad de la fisión en el átomo. Hasta 1932 se había supuesto constantemente que, si el núcleo tenía partes, las partes serían cargas eléctricas. En aquel año, sin embargo. James Chadwick (nacido en 1891) mostró que las pruebas indicaban de modo concluyeme la existencia de alguna parte del núcleo que es eléctricamente neutra; surgió así la moderna imagen del núcleo como formado por dos clases de partículas fundamentales, protones positivos y neutrones neutros, mantenidos juntos por una no explicada energía unidora.

El descubrimiento del neutrón proporcionó una partícula que podía bombardear el núcleo sin ser rechazada por la repulsión eléctrica. Se hizo de este modo concebible que cabía entrar en el núcleo, hacerlo inestable y forzarlo así a liberar su enorme energía unidora. Esta acción, si liberaba nuevos neutrones, podría propagarse por sí misma. Y así resultó. En 1938, los físicos alemanes Otto Hahn (nacido en 1879) y Fritz Strassmann (nacido en 1902) probaron que tal fisión puede ocurrir en variantes atómicas o isótopos del uranio. La estructura del antes indivisible átomo no solamente podía ser descrita: podía ser destruida.

Se descubrió que el tiempo y el espacio, que en el sistema newtoniano habían sido considerados absolutos, eran relativos. Este revolucionario descubrimiento fue hecho al intentar resolver las discrepancias entre la observación y la teoría, particularmente las cuestiones planteadas por las características peculiares de la luz, que se hicieron manifiestas al tratar de determinar el carácter del éter, y por observaciones que mostraban una relación entre masa y energía.

La nueva serie de partículas unidas que entraron en la física con el descubrimiento del electrón procuraron fundamento a la idea de que toda materia podía ser una configuración de cargas eléctricas. J. J. Thomson, que había trabajado durante mucho tiempo en la matemática de esta teoría, había ya mostrado en 1881 que una carga eléctrica en movimiento se manifestaría como teniendo masa. Luego se vio que los veloces electrones cambiaban su masa con su velocidad y comenzó así a parecer probable que entre masa y energía existiera una relación.

Pero la energía tenía que ser conducida a través de algún medio. Subsistía el enigma, el de descubrir este medio que penetraba en todo, el éter. Albert Abraham Michelson (1853-1931) y Edward Williams Morley (1838-1923) heredaron en 1887 un experimento que forzaría a revelar su presencia. Michelson y Morley alegaban que, si el éter era un medio que conducía las ondas de luz como el aire conduce el sonido o el mar las ondulaciones del agua, tenía que ser posible descubrir el paso de la Tierra por el éter y aclarar de este modo la naturaleza del éter mismo. Por ejemplo, si un barco se desplaza en un mar tranquilo, las ondas que provoca parecen, desde el barco, viajar a lo largo de la línea de movimiento de éste a diferente velocidad de la que viajan en ángulos rectos respecto a la línea de movimiento. Estas diferencias pueden ser utilizadas para calcular la velocidad del barco por el mar; Michelson y Morley esperaban calcular la velocidad de la Tierra a través del éter mediante un perfeccionamiento de este método.

La luz, ay, insistió obstinadamente en viajar a la misma velocidad, fuera cual fuese la dirección en que era enviada al éter y con independencia del movimiento de la fuente luminosa. Es decir, la luz cubría una distancia dada a través de la superficie de la Tierra en el mismo tiempo, con independencia de la velocidad o la dirección del objeto terrestre en movimiento que emitía esa luz. Se vio que la velocidad de la luz era absoluta; no se comportaba del mismo modo que otras velocidades, como las del sonido o las ondas acuáticas, que están afectadas por cómo la fuente emisora se mueve por el medio aire o agua— que las conduce.

Este impresionante mal comportamiento fue un escándalo para la ciencia clásica durante varios años. Físicos eminentes, como George Fruncís Fitzgcrald (1851-1901), y matemáticos eminentes, como Henri Poincaré (1854-1912), propusieron diversas correcciones, incluidas algunas cuyo efecto seria cancelar la velocidad de la Tierra a través del éter. Pero aunque Poincaré avanzó mucho hacia una nueva formulación, le correspondió a un joven de veintiséis años, Albert Einstein (1879-1955), el publicar en 1905 un informe que puso la cuestión en su perspectiva natural.

Einstein no buscó errores infinitesimales de formulación en las leyes de la física ni algún recurso ingenioso para corregirlos. En lugar de esto, siguió un procedimiento filosófico propuesto primeramente por el físico austriaco Ernst Mach (1838-1916). Se puso a analizar las presunciones no escritas sobre las que las mismas leyes habían sido edificadas y se preguntó si no podía estar allí escondido el fallo en la física del siglo xix. La presunción no escrita que puso en tela de juicio fue la de que el tiempo y el espacio se nos dan con un carácter absoluto. Que esto no era más que una presunción fue evidente para Isaac Newton cuando hizo sus grandes descubrimientos como joven de veintitrés años, pero los científicos menores que lo siguieron apenas habían dedicado al tema un pensamiento. Aceptaron el espacio y el tiempo como cajas listas para su uso proporcionadas por la naturaleza y dentro de las cuales ocurren los sucesos que observamos.

Pero, se preguntó Einstein, ¿se nos dan listos para el uso el espacio y el tiempo? ¿Cómo lleva a cabo el observador físico el proceso de medirlos? Por ejemplo, ¿cómo dos observadores separados por una distancia comparan sus tiempos? Sólo pueden hacerlo, observó, enviando una señal del uno al otro y la misma señal necesita tiempo para viajar a través del espacio entre ellos. La señal, de hecho, es un rayo de luz o una análoga onda o perturbación electromagnética y no es posible prescindir de su velocidad en la medición. Se deduce de esto que no hay ningún modo abstracto o impersonal con el que podamos definir el «ahora» para todos los observadores de todas partes simultáneamente. Todo observador tiene únicamente su propio «aquí y ahora». En nuestra experiencia del mundo físico, el espacio y el tiempo no pueden ser totalmente separados el uno de! otro; cada uno de ellos es parte de una sola realidad. Y el paso de señales luminosas de un punto del espacio a otro es el lazo esencial entre el tiempo en los dos puntos.

Con este análisis, que constituye la teoría especial de la relatividad, Einstein resolvió la paradoja del experimento de Miehelson y Morley de una vez por todas.» Su tesis se mantuvo como fundamental para la física desde la fecha de la publicación de su informe.11

Además, una vez relacionados el tiempo y el espacio, como Einstein los relacionaba, por señales luminosas, la masa y la energía quedaban también relacionadas. Einstein mostró en el mismo informe que su teoría de la relatividad suponía una equivalencia fundamental entre masa y energía. La relación entre ellas podía ser expresada por una ecuación que incluye la velocidad de la luz como una constante fundamental; cada partícula de materia representa una energía que puede ser medida por el producto de su masa por el cuadrado de la velocidad de la luz, E = mc2. Masa y energía fueron vistas así como dos modos diferentes de experimentar una sola realidad.

La teoría de los «quanta». las investigaciones matemáticas

Se descubrió que la energía, a la que el siglo XIX había supuesto continua e infinitamente, divisible, consistía en unidades separadas que no podían ser subdivididas.

En el siglo XIX se había pensado que la materia consistía en átomos separados, pero se había supuesto que la energía pasaba de un trozo de materia a otro de un modo continuo. Esto es. se presumía que podemos transferir una cantidad de energía tan pequeña como queramos de un trozo de materia a otro. Se suponía que, en contraste con la materia, la energía podía ser dividida una y otra vez, en cantidades siempre menores, sin límite, indefinidamente.

Había, sin embargo, algunos fenómenos en la radiación de energía de un cuerpo caliente que obstinadamente se resistían a entrar en el esquema. Los matemáticos estaban perplejos, pero a nadie se le ocurría rechazar la presunción fundamental. Luego, en 1899. el físico teórico Max Planck (1858-1947} lo hizo, recelosamente pero con impresionantes consecuencias. Mostró que la distribución de la energía incluida en las diferentes longitudes de onda cuando un cuerpo caliente está irradiando podía ser explicada, perfectamente explicada, pero basándose en una presunción distinta.

Debemos presumir, dijo Planck, que la energía es emitida a trozos, en destellos individuales, como si fuera unidad por unidad; que no ondea desde un cuerpo radiante de un modo continuo, sino que sale de él corno un raudal de halas. Las balas, los

Max Planck. Fotografía de1943. En 1899, el físico teórico Max Planck mostró que la distribución de la energía incluida en las diferentes longitudes de onda onda cuando un cuerpo caliente está irradiando podía ser explicada. En una longitud de onda cualquiera, la energía sólo puede ser transferida en unidades de una cantidad fija. Planck llamó a esta cantidad mínima un quantum (un cuanto). Foto Agencia AGE,

trozos, son realmente muy pequeños, pero esto es el quid de la explicación— su tamaño para cualquier longitud de onda es fijo; no puede ser subdividido más. En una longitud de onda cualquiera, la energía sólo puede ser transferida en unidades de una cantidad fija. Planck llamó a esta cantidad mínima un quantum (un cuanto).

Planck sabía muy bien que su explicación se apartaba radicalmente de la física clásica. Sin embargo, se mantuvo poco dispuesto a avanzar hasta las últimas consecuencias de lo que había propuesto. Esto lo dejó para otros físicos más jóvenes, entre los que uno de los más audaces fue de nuevo Albert Einstein. Estos jóvenes no vacilaron en decir lo que el descubrimiento de Planck significaba.

Significaba que la energía tiene una estructura, cierto carácter granular o tosco, muy al modo de la materia. Así como la materia puede ser desintegrada en sus partículas fundamentales pero no más. la energía puede ser rota en (¡nauta (en cuantos), pero no más. Los cuantos representan en cierto modo el mismo papel en el movimiento de la energía que las partículas fundamentales protones, neutrones y electrones— representan en la ordenación en la materia.

Si ello es así, razonó Einstein la radiación de una determinada longitud de onda —por ejemplo, la luz amarilla de sodio— debe estar formada por cuantos que son todos ellos iguales. Cuando los átomos de sodio son calentados, estos cuantos iguales salen disparados individualmente, como si fueran en un sentido partículas de luz. Esta visión de la luz como un chorro de partículas separadas o fotones fue reconocida como una de las grandes contribuciones a la física de Einstein cuando se le concedió el premio Nóbel en 1921.

Los físicos Wilheltm Oseen, Nils Bahr, James Franck. Osear Klein y Max Born en una reunión de científicos en 1921. Foto Agencia AGE.

Pero subsistía aún el enigma básico; si la luz puede ser descrita como formada por partículas separadas, ¿por qué también se comporta como si se moviera en una onda? Max Born (nacido en 1882) dio la respuesta a esta pregunta en la década de 1920. Las ondas de luz son ondas de probabilidad, ondas que describen únicamente dónde tenemos más y dónde menos probabilidades de encontrar un fotón individual en cualquier instante dado. Y si fijamos nuestra atención en un fotón individual, su posición en un instante cualquiera sólo puede ser descrita como una probabilidad; no es una posición determinada, sino probable (véase la nota adicional 3 de final de capítulo).

Estos cambios en la perspectiva de la física fueron a la par con un nuevo interés por la matemática. En cierto modo, la conexión era evidente: la nueva física necesitaba nuevas clases de matemática. Pero en otro modo la conexión era más sutil. Era como si matemáticos y físicos, frecuentemente sin que los unos conocieran las ideas de los otros, llegaran a interesarse al mismo tiempo en temas como la discontinuidad y la probabilidad. Pareció frecuentemente que los matemáticos puros, que estaban totalmente divorciados de la física, habían elaborado una técnica incluso antes de que los físicos la necesitaran. En contraste, allí donde la matemática estaba estrechamente ligada con la física, como en Gran Bretaña, los matemáticos no desarrollaron muchas veces por adelantado las técnicas necesarias para expresar las nuevas ideas revolucionarias de los físicos.

Aunque el estudio de la probabilidad y de la estadística matemática había comenzado en el Renacimiento, cuando fueron planteados por primera vez problemas de seguridad y juegos de azar, sólo hacia el 1900 comenzaron a manifestarse los conceptos básicos y fundamentales del razonamiento estadístico. Estos conceptos se apoyaban a la vez en la matemática del raciocinio sobre probabilidades desarrollada en el siglo xvii y en la teoría de distribución de errores de observación elaborada por Cari Friedrich Gauss (1777-1855) a comienzos del siglo XIX.

Profesor de la Universidad de Wisconsin en plena demostración de un problema de cálculo de probabilidades relacionado con las técnicas estadísticas. Servicio Documental Planeta.

La esencia del razonamiento estadístico, según fue desarrollado por Andrei Andreevich Markov (1856-1922), A. Liapunov (1857-1918) y otros en Rusia y por Karl Pearson (1857-1936) y, más adelante, Ronald Aylmer Fisher (nacido en 1890) en Gran Bretaña, era que no se refería a cuestiones bien delimitadas y evidentes por sí mismas, blanco frente a negro. Se refería a fenómenos que pueden ser descritos y muchas veces explicados de diferentes modos y donde, por consiguiente, hay que hacer un juicio y optar por la descripción o la explicación que parezca ajustarse mejor a los hechos. Lo que la estadística matemática podía hacer no era ocupar el lugar de juicios tales, sino proporcionar instrumentos que ayudaran a restringir el campo del juicio y a orientar los juicios mediante el suministro de una base cuantitativa, sólida en el paso de una ocasión a otra.

El razonamiento estadístico era innecesario para describir y explicar fenómenos bien delimitados como la fuerza de gravitación. Nt> hace falta un razonamiento estadístico para demostrar que un trozo de materia caerá al suelo si lo soltamos ni para establecer de un modo convincente que la fuerza de gravitación que se postula para explicar este efecto explicará también los movimientos de la Luna y los planetas. Los fenómenos y las explicaciones están bien delimitados, pueden ser formulados en ecuaciones precisas y, tan pronto como Isaac Newton lo hizo, el acuerdo entre la observación y la explicación se consideró evidente.

En una cuestión peor delimitada, como, por ejemplo, la eficacia de un medicamento, la situación es muy distinta. Todo experimento destinado a determinar la eficacia del medicamento está oscurecido por inevitables e importantes variaciones: los pacientes se hallan en muchas fases de la enfermedad; su reacción está inevitablemente influida por muchos factores en su salud general y su condición física.

Las técnicas estadísticas ofrecen un modo de obtener resultados positivos en un campo variable como éste. En esencia, preguntan con qué frecuencia el resultado al que se ha llegado ha podido ser obtenido por mera casualidad. Al hacer esto, posibilitan distinguir entre resultados observados que pudieron producirse por casualidad y aquellos que muestran un grado de consistencia que hace improbable que procedan del azar y que pueden, por consiguiente, fundamentar la presunción de que están relacionados con la influencia cuyo efecto está siendo estudiado.

El planteamiento estadístico es esencialmente sencillo en su concepción. En el fondo, divide los fenómenos observados en dos partes, aquellos que son fortuitos, atribuibles a la casualidad, y aquellos que son sistemáticos, representación de un efecto. O sea, el planteamiento estadístico reconoce que un efecto puede ser aislado únicamente hasta cierto grado de exactitud y que, con el fin de determinar si un efecto es real, es necesario comparar su zona de incertidumbre con la exactitud con que puede ser medido. El efecto debe ser juzgado en relación con el error al que el cálculo está expuesto. Si el efecto se muestra francamente por encima del error, el resultado puede ser considerado como significativo. Pero si el efecto no se manifiesta considerable cuando es comparado con los inherentes errores de medición, la significación no queda establecida. El efecto puede de hecho existir, pero la zona de incertidumbre es demasiado grande para que sea permisible una conclusión así. La única esperanza estriba entonces en reunir más observaciones hasta que reduzcan la zona de incertidumbre hasta un punto en que la conclusión, aunque no libre de incertidumbre todavía, resulte útil.

Hacia el 1900, los matemáticos llegaron a sentir un nuevo interés por los problemas de relación y de estructura. El planteamiento estadístico suponía un sentido menos rígido y, en algunos aspectos, más sutil y perfeccionado de la relación entre sucesos del que estaba expresado en la convicción del siglo XIX de que todo podía ser dicho por unos cuantos números precisos. Los matemáticos mostraron un interés creciente en las conexiones lógicas y las relaciones generales que podían ser descritas geométricamente.

En Italia fue creada una importante escuela de geometría moderna, en gran parte por inspiración de Corrado Segre (1863-1924). Partiendo de la desdeñada obra de precursores alemanes como Hermann Grassmann (1809-1877), exploró las propiedades de espacios no euclidianos y, más adelante, las funciones algebraicas que pueden ser construidas en ellos.12

Otros geómetras llevaron todavía más lejos la liberación frente a las restricciones del espacio euclidiano. Encabezados por Henri Poincarc, entre otros, comenzaron a investigar los movimientos más generales con los que una figura geométrica puede ser deformada hasta adquirir la forma de otra, por los que tal superficie cerrada de un cubo puede ser estirada hasta que se adapte a la superficie de una esfera, pero no puede en modo alguno ser estirada hasta que se ajuste a la superficie de un anillo. Esto se convirtió subsiguientemente en el tema de la topología y se reveló como uno de los campos más fecundos de la matemática moderna.

Al mismo tiempo, fueron estudiadas las propiedades locales y de escala menor de estructuras no euclidianas inspirándose en la obra de George Friedrich Bernhard Riemann (1826-1866)13. A partir de esta obra se desarrolló una forma más general del cálculo diferencial, forma que más adelante resultó esencial para la matemática de la relatividad.

En estas y otras ampliaciones de la matemática tradicional se desarrolló un nuevo concepto básico: el concepto de la operación. Hizo que la matemática fuera considerada no como una serie de números unidos por ecuaciones, sino como una serie de estructuras transformadas unas en otras por operaciones. La atención se desplazó, por ejemplo, del coeficiente diferencial como una medida a la operación de diferenciación como un proceso. 1:1 matemático llegó a verse como un agente activo, como un hombre que efectúa operaciones nuevas.

La presunción básica de la matemática, la de que los números enteros están dados por Dios y son cosas en sí mismos, fue sometida al mismo escrutinio que se impuso a la presunción del físico de que el espacio y el tiempo son absolutos. Con el paso de un siglo al otro, los matemáticos comenzaron a reconocer que los números enteros describen relaciones entre cosas. Así como el espacio y el tiempo describen relaciones físicas, los números describen relaciones lógicas; el número 2, por ejemplo, describe alguna relación lógica común a todos los pares de cosas que pueden ser imaginados. Se vio que los números tenían que ser elaborados y definidos, desde la misma base, como relaciones. Giuseppe Peano (1858-1932) y otros se dedicaron hacia 1900 a formular tales definiciones lógicas para los números y más generalmente para las operaciones de la aritmética. Alfred North Whitehead (1861-1947» y Bertrand Russell (1872-1971) fueron más lejos y trataron desde estos comienzos de establecer toda la matemática como una expresión formal de relaciones lógicas.

Bertrand Russell

Durante este trabajo, Whitehead y Russell descubrieron algunas inopinadas presunciones en los mismos cimientos de la matemática. Al mismo tiempo, mostraron que la expresión simbólica del pensamiento, sea en lenguaje o en otros símbolos, reclama un análisis mucho más sutil del que había sido objeto hasta entonces. Buena parte del análisis filosófico del siglo XX y especialmente el movimiento filosófico iniciado por Ludwig Wittgenstein (1889-1951), discípulo de Russell, fueron puestos en acción por estos descubrimientos en la semántica de todas las formas simbólicas de expresión.

Entre las dificultades que Whitehead y Russell no resolvieron estaba, sin embargo, la cuestión planteada por el matemático David Hilbert (1862-1943): ¿es realmente evidente, es tan siquiera cierto, que cuando se ha establecido un sistema de axiomas como el de Euclides toda proposición verdadera puede ser probada partiendo de estos axiomas, del mismo modo que toda proposición falsa puede ser refutada? ¿No es posible que haya proposiciones que no puedan ser ni probadas ni refutadas en un número finito de pasos?

En 1931, Kurt Godel (nacido en 1906) mostró que es en verdad posible. Cualquier conjunto lógico de ideas matemáticas que tenga una base axiomática lo bastante rica, en un sentido técnico, para permitir la formulación de declaraciones y preguntas significativas, resulta también lo bastante rico para que se puedan formular preguntas que no tienen contestación dentro del sistema. No es que estas preguntas no tengan contestación por la razón práctica de que son demasiado difíciles: es que teóricamente no tienen contestación.

David Hilbert. Entre las dificultades que Whiifheud y Russell no resolvieron estaba, sin embargo, la cuestión planteada por el matemático David Hilbert: ¿no es posible que haya proposiciones que no puedan ser ni probadas ni refutadas en un número finito de planos? Foto Agencia AGE.

Este descubrimiento abrió un abismo en los mismos cimientos de la matemática: la presunción de que, en un sistema de matemática, todas las proposiciones se ajustan a sus axiomas o los contradicen. Asestó un duro golpe a la noción de verdad y falsedad, pues la verdad ya no puede basarse en una mera consistencia formal si hay proposiciones que, dentro de un sistema dado, no son ni verdaderas ni falsas en ningún sentido electivo. Socavó el método de desarrollar la ciencia desde una serie de axiomas, pero no ofreció un método alternativo. Los plenos efectos de este descubrimiento sólo se manifestarían al extrapolarse de la aritmética y la matemática a las ciencias empíricas.

Fuente: Historia de la Humanidad, Unesco, Vol Siglo XX